南开大学22春《网络爬虫与信息提取》在线作业二及答案参考99

南开大学22春《网络爬虫与信息提取》在线作业二及答案参考99

《南开大学22春《网络爬虫与信息提取》在线作业二及答案参考99》由会员分享,可在线阅读,更多相关《南开大学22春《网络爬虫与信息提取》在线作业二及答案参考99(13页珍藏版)》请在装配图网上搜索。

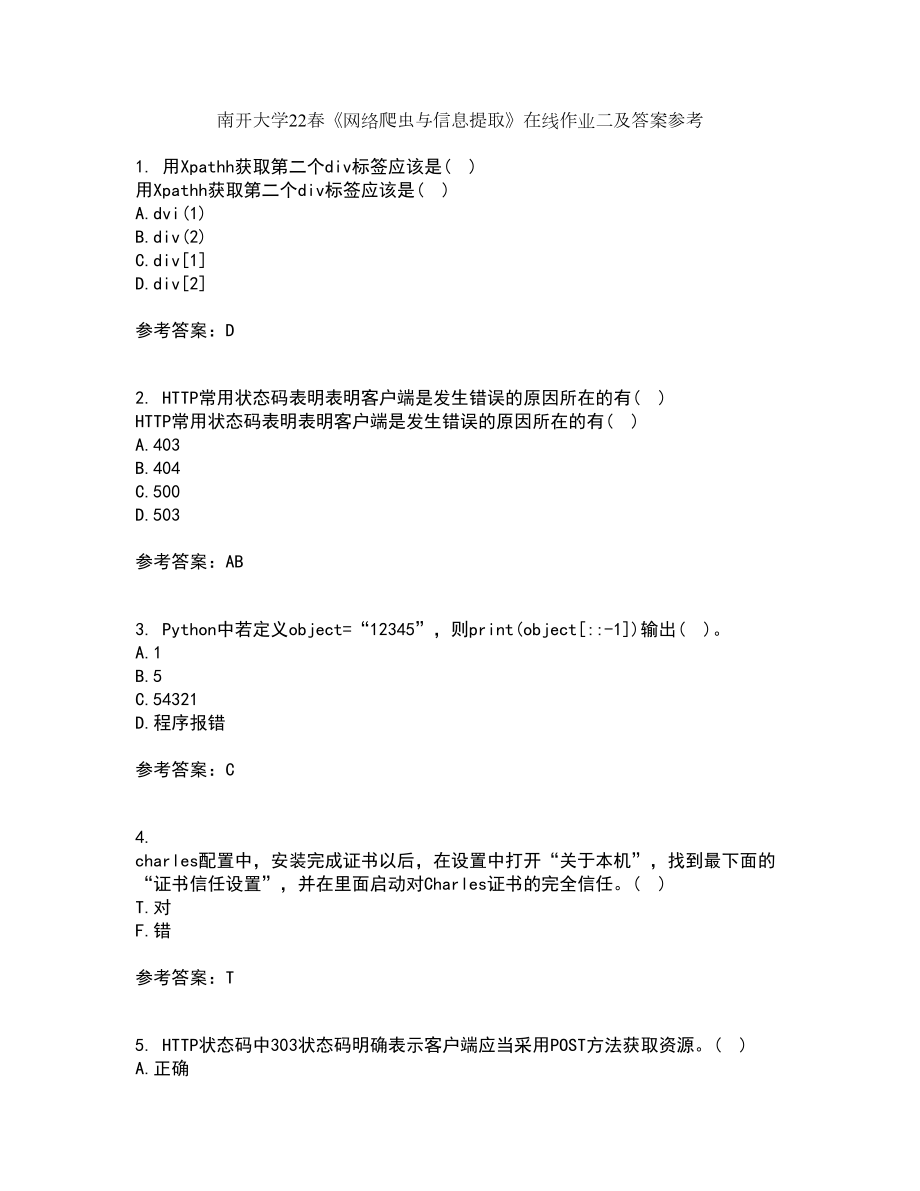

1、南开大学22春网络爬虫与信息提取在线作业二及答案参考1. 用Xpathh获取第二个div标签应该是( )用Xpathh获取第二个div标签应该是( )A.dvi(1)B.div(2)C.div1D.div2参考答案:D2. HTTP常用状态码表明表明客户端是发生错误的原因所在的有( )HTTP常用状态码表明表明客户端是发生错误的原因所在的有( )A.403B.404C.500D.503参考答案:AB3. Python中若定义object=“12345”,则print(object:-1)输出( )。A.1B.5C.54321D.程序报错参考答案:C4. charles配置中,安装完成证书以后,

2、在设置中打开“关于本机”,找到最下面的“证书信任设置”,并在里面启动对Charles证书的完全信任。( )T.对F.错参考答案:T5. HTTP状态码中303状态码明确表示客户端应当采用POST方法获取资源。( )A.正确B.错误参考答案:B6. 为了保证数据插入效率,在内存允许的情况下,应该一次性把数据读入内存,尽量减少对MongoDB的读取操作。( )T.对F.错参考答案:T7. 爬虫中间件的作用对象是请求request和返回response。( )爬虫中间件的作用对象是请求request和返回response。( )A.正确B.错误参考答案:B8. 在Scrapy的目录下,哪个文件负责定

3、义需要爬取的数据?( )A.spiders文件夹B.item.pyC.pipeline.pyD.settings.py参考答案:B9. 在对XPath返回的对象再次执行XPath的时候,子XPath开头需要添加斜线。( )T.对F.错参考答案:F10. Python正则表达式模块的findall方法如果没有匹配到结果,则返回结果为( )Python正则表达式模块的findall方法如果没有匹配到结果,则返回结果为( )A.空B.空列表C.空元组D.不返回参考答案:B11. 当使用Scarpy创建爬虫时,当爬取网易云音乐首页信息时,scrapy genspider的第二个参数直接输入就可以了。(

4、 )当使用Scarpy创建爬虫时,当爬取网易云音乐首页信息时,scrapy genspider的第二个参数直接输入就可以了。( )A.正确B.错误参考答案:B12. 使用UI Automatorr输入文字的操作是得到相应控件后使用命令( )使用UI Automatorr输入文字的操作是得到相应控件后使用命令( )A.settextB.setC.set_textD.text参考答案:C13. 爬虫登录需要识别验证码可以先把程序关闭,肉眼识别以后再重新运行。( )A.正确B.错误参考答案:B14. 在安装Scarpy的依赖库时,由于Visual C+ Build Tools的安装速度很慢,为了节省

5、时间,可以和安装Twisted同时进行。( )T.对F.错参考答案:F15. Redis是遵守BSD协议、支持网络、可基于内存亦可持久化的日志型、Key-Value数据库。( )T.对F.错参考答案:T16. 一般来说在页面都通过GET将用户登录信息传递到服务器端。( )一般来说在页面都通过GET将用户登录信息传递到服务器端。( )A.正确B.错误参考答案:B17. Charles和Chrome开发者工具相比,只是多了一个搜索功能。( )A.正确B.错误参考答案:B18. 微信小程序的反爬虫能力要比网页的高很多。( )微信小程序的反爬虫能力要比网页的高很多。( )A.正确B.错误参考答案:B1

6、9. 使用UI Automatorr让屏幕向右滚动的操作是得到相应控件后使用命令scroll.horiz.forward( )。( )T.对F.错参考答案:F20. 自己能查看的数据,允许擅自拿给第三方查看。( )T.对F.错参考答案:F21. Redis中往集合中读数据,使用关键字( )A.popB.spopC.lpopD.range参考答案:B22. Python中直接对浮点数进行计算有print(0.1+0.2),则结果为0.3。( )A.正确B.错误参考答案:B23. Python中( )与元组由类似的数据读取方式。A.字符串B.列表C.字典D.集合参考答案:AB24. Scrapyd

7、可以同时管理多个Scrapy工程里面的多个爬虫的多个版本。( )T.对F.错参考答案:T25. HTTP常用状态码表明服务器正忙的是( )。A.500B.503C.403D.404参考答案:B26. 插入数据时,MongoDB会自动添加一列“_id”,也就是自增ID,每次自动加1。( )T.对F.错参考答案:F27. 当使用Scarpy创建爬虫时,当爬取网易云音乐首页信息时,scrapy genspider的第二个参数直接输入就可以了。( )T.对F.错参考答案:F28. Redis中列表读取数据命令lrange中l代表left,即从左侧开始读取。( )Redis中列表读取数据命令lrange

8、中l代表left,即从左侧开始读取。( )A.正确B.错误参考答案:B29. RoboMongo是MongoDB的管理软件。( )T.对F.错参考答案:T30. Redis中往集合中添加数据,使用关键字( )Redis中往集合中添加数据,使用关键字( )A.saddB.addC.appendD.sappend参考答案:A31. Python正则表达式模块的findall方法提取内容包含多个,则返回结果的列表中会包含( )Python正则表达式模块的findall方法提取内容包含多个,则返回结果的列表中会包含( )A.列表B.元组C.字典D.集合参考答案:B32. 网站返回的Headers中经常

9、有Cookies,可以用mitmdump脚本使用print函数把Cookies打印出来。( )网站返回的Headers中经常有Cookies,可以用mitmdump脚本使用print函数把Cookies打印出来。( )A.正确B.错误参考答案:B33. 爬虫的源代码通过公开不会对被爬虫网站造成影响。( )A.正确B.错误参考答案:B34. 常用的会话跟踪技术是( )A.sessionB.cookiesC.moonpiesD.localstorage参考答案:AB35. HTTP常用状态码表明表明服务器本身发生错误的有( )HTTP常用状态码表明表明服务器本身发生错误的有( )A.403B.40

10、4C.500D.503参考答案:CD36. Python中定义函数关键字为( )。A.defB.defineC.funcD.function参考答案:A37. 下面Python代码输出为( ):def default_para_without_trap(para=, value=0): if not para: p下面Python代码输出为( ):def default_para_without_trap(para=, value=0): if not para: para = para.append(value) return para print(第一步:.format(default_p

11、ara_trap(value=100) print(第二步:.format(default_para_trap(value=50)A.第一步:100 第二步:100,50B.第一步:100 第二步:50C.第一步:100 第二步:D.第一步:100 第二步:100参考答案:B38. MongoDB 是一个基于分布式文件存储的数据库,速度远快过Redis。( )A.对B.错参考答案:B39. BS4可以用来从( )中提取数据A.HTMLB.XMLC.数据库D.JSON参考答案:AB40. 要使用tesseract来进行图像识别,需要安装两个第三方库( )要使用tesseract来进行图像识别,需

12、要安装两个第三方库( )A.requestsB.beautifulsoupC.PillowD.pytesseract参考答案:CD41. 在请求头中设置User-Agent即可正常请求网站。( )在请求头中设置User-Agent即可正常请求网站。( )A.正确B.错误参考答案:B42. 运行MongoDB以后,不会在终端打印任何Log。( )运行MongoDB以后,不会在终端打印任何Log。( )A.正确B.错误参考答案:B43. Redis中使用lrange读取数据后数据也会删除。( )A.正确B.错误参考答案:B44. Redis中从集合中查看有多少个值,用关键字( )。A.scardB

13、.cardC.countD.distinct参考答案:A45. 当爬虫创建好了之后,可以使用“scrapy( )”命令运行爬虫。A.startupB.starwarC.drawlD.crawl参考答案:D46. 如果通过爬虫抓取某公司网站的公开数据,分析以后发现这个公司业绩非常好。于是将数据或者分析结果出售给某基金公司,从而获得销售收入。这是合法的。( )A.正确B.错误参考答案:A47. 以下哪些可以独立成为Python编译器( )以下哪些可以独立成为Python编译器( )A.PycharmB.IDLEC.EclipseD.Visual Studio 2010参考答案:AB48. 下列说法

14、错误的是( )。A.小程序的请求极其简单,基本上没有验证信息B.用Python来请求小程序的后台接口从而获取数据,比请求异步加载网页的后台接口要复杂很多C.如果目标网站有微信小程序,那么一定要优先调查能否通过小程序的接口来抓取数据D.小程序的反爬虫能力比网页版的低很多。使用小程序的接口来爬数据,能极大提高爬虫的开发效率参考答案:D49. scrapy与selenium结合可以实现直接处理需要异步加载的页面。( )T.对F.错参考答案:T50. Python中列表生成以后还可以往里面继续添加数据,也可以从里面删除数据。( )T.对F.错参考答案:T51. 以下哪个HTML标签表示定义文档的主体(

15、 )以下哪个HTML标签表示定义文档的主体( )A.divB.bodyC.headD.footer参考答案:B52. 在使用多线程处理问题时,线程池设置越大越好。( )A.正确B.错误参考答案:B53. Python中包含字典的列表页可以转换成JSON字符串。( )Python中包含字典的列表页可以转换成JSON字符串。( )A.正确B.错误参考答案:A54. 在Linux的终端使用apt-get命令安装一系列依赖库时,其中如果存在有已经安装的库,会覆盖掉之前的库重新安装。( )在Linux的终端使用apt-get命令安装一系列依赖库时,其中如果存在有已经安装的库,会覆盖掉之前的库重新安装。(

16、 )A.正确B.错误参考答案:B55. 在Scrapy的目录下,哪个文件负责存放爬虫文件?( )A.spiders文件夹B.item.pyC.pipeline.pyD.settings.py参考答案:A56. 在Scrapy的目录下,哪个文件负责存放爬虫的各种配置信息?( )A.spiders文件夹B.item.pyC.pipeline.pyD.settings.py参考答案:D57. MongoDB中可以将( )数据结构插入集合中A.列表B.元组C.字典D.集合参考答案:C58. Redis的集合与Python的集合一样,没有顺序,值不重复。( )Redis的集合与Python的集合一样,没有顺序,值不重复。( )A.正确B.错误参考答案:A59. HTTP状态码503表示服务器内部故障。( )T.对F.错参考答案:F60. Cookies一般包含在请求头Headers中。( )A.正确B.错误参考答案:A

- 温馨提示:

1: 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

2: 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

3.本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

5. 装配图网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。