信息论第三讲

信息论第三讲

《信息论第三讲》由会员分享,可在线阅读,更多相关《信息论第三讲(8页珍藏版)》请在装配图网上搜索。

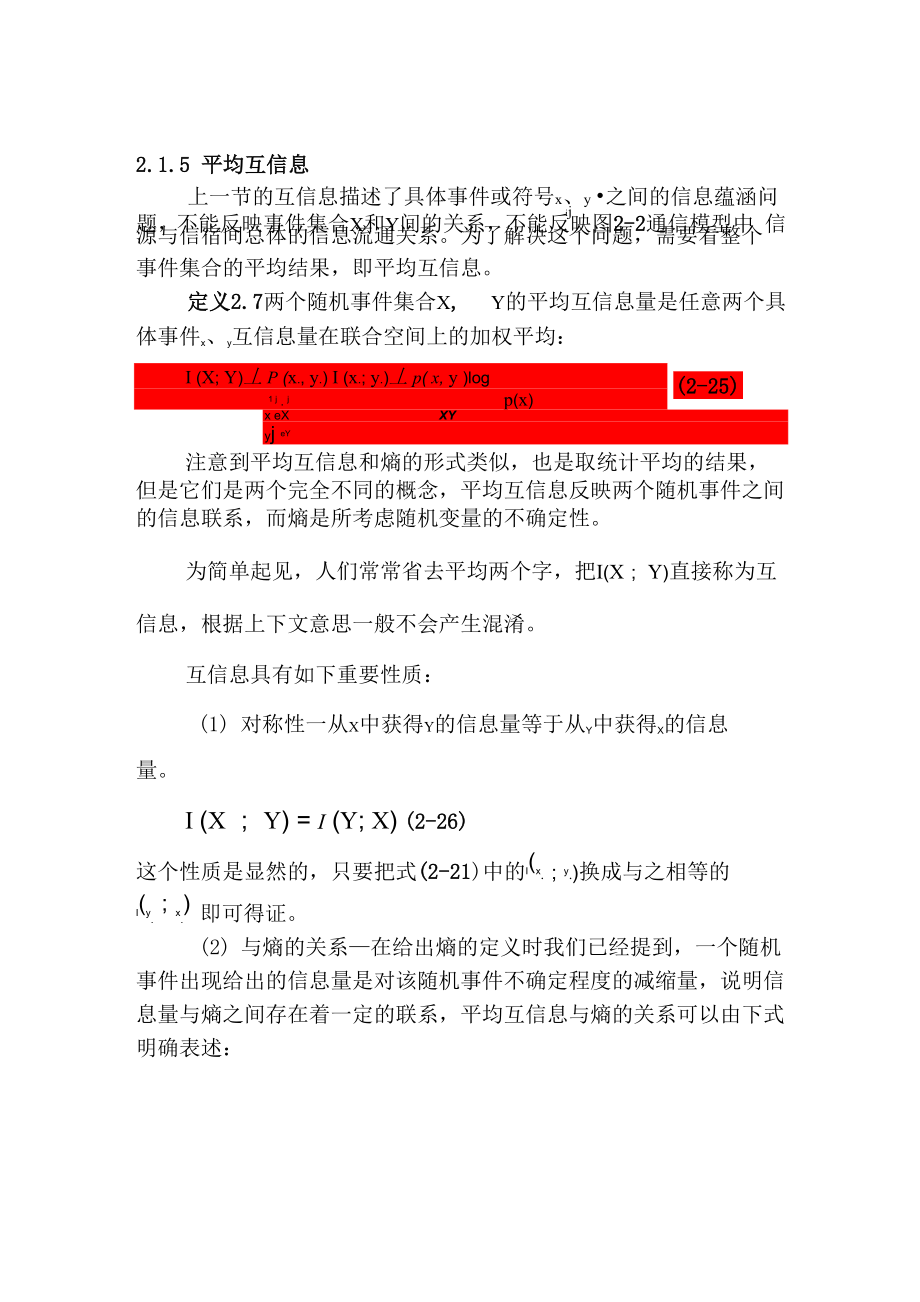

1、2.1.5 平均互信息上一节的互信息描述了具体事件或符号x、y 之间的信息蕴涵问 ij题,不能反映事件集合X和Y间的关系,不能反映图2-2通信模型中 信源与信宿间总体的信息流通关系。为了解决这个问题,需要看整个事件集合的平均结果,即平均互信息。定义2.7两个随机事件集合X, Y的平均互信息量是任意两个具 体事件x、y互信息量在联合空间上的加权平均:(2-25)I (X; Y)丄 P (x., y.) I (x.; y.)丄 p( x, y )log1 j . jp(x)x eXXYyj eY注意到平均互信息和熵的形式类似,也是取统计平均的结果, 但是它们是两个完全不同的概念,平均互信息反映两个

2、随机事件之间 的信息联系,而熵是所考虑随机变量的不确定性。为简单起见,人们常常省去平均两个字,把I(X; Y)直接称为互信息,根据上下文意思一般不会产生混淆。互信息具有如下重要性质:(1) 对称性一从X中获得Y的信息量等于从Y中获得X的信息量。I (X ; Y) = I (Y; X)(2-26)这个性质是显然的,只要把式(2-21)中的I(x.;y.)换成与之相等的I(y.;x.) 即可得证。(2) 与熵的关系在给出熵的定义时我们已经提到,一个随机 事件出现给出的信息量是对该随机事件不确定程度的减缩量,说明信 息量与熵之间存在着一定的联系,平均互信息与熵的关系可以由下式 明确表述:I(X; Y

3、)二p(x, y) log p(x) +p(x, y) log p(x I y)XYXY=H (X) H (X I Y)(2-27)这个式子的物理意义可以这样解释:对x的不确定度减去已知Y情况下对X的不确定程度,就是Y所能够提供的关于X的信息量。同理可I (Y; X)二 H (Y) H (Y I X)(2-28)特别地,I(X; X) = H (X) - H (X I X) = H (X)(2-29)式中H(X I X)二0是明显的,因为已知X后对X当然就不存在不确定性 了。此式表明,随机变量与其自身的互信息即为该随机变量的熵。把式 (2-15)代入式(2-28)可以得到一个均衡的表达式:I

4、(X;Y) = H( X)+H(Y)H( X, Y)(2-30)平均互信息和熵都是信息论里最重要的基本概念,弄清楚它们的关系 对深入理解信息论的知识非常有意义。(3) 非负性一随机变量集合X、Y的互信息量不小于0,即卩I ( X ;Y) 0(2-31)当且仅当 X、 Y 互相独立时,等号成立。这一点与两个随机变量的互信息I (xi ; y7J不同,后者可为任何实数。关于平均互信息的非负性我 ij们留待下一节证明。例2.8已知等概信源发出符号x 1或x2,信道特性如图2-3所示,求在该信道上传输的平均互信息量I(X;Y)、疑义度H(X I Y)、噪声熵H(Y I X)和联合熵H(XY)。0. 9

5、8图 2-3 例 2.8解 先求出各联合概率:P(X, yi)= P(X)P(yi I X) = 0.5 x 0.98 = 0.49P(x, y2)= P(x)P(y2 I x) = 0.5 x 0.02 = 0.01P(X2,y)= P(X2)P(y | X2)=0.5x0.20=0.0P(X2,y2)= P(X2)P(y2 I X2)=0.5x0.80=0.40再根据全概率公式求出Y集合中各符号的概率: 的信道特性P(y) = P(x)P(y I x) + P(x2)P(y I x2)=0.5 x 0.98 + 0.5 x 0.2 = 0.59P( y 2)= 1 - 0.59 = 0.4

6、1第三步求出各后验概率:P(X1 I y1) = P(X1,y1)/P(y1) = 0.49 / 0.59 = 0.831 P(X2 I y1) = P(X2,y1)/P(y1) = 0.10 / 0.59 = 0.169 P(X1I y2)= P(X1,y2)/P(y2)=0.01/0.41=0.024 P(X2 I y2)= P(X2,y2)/P(y2)=0.40/0.41=0.976 2 2 2 2 2现在可以计算各种熵了。联合熵为2H (XY)=-比P( x., yj) log P( x., yj)i ji j. =1 j =1=-(0.49 log 0.49 + 0.011og 0.

7、01 + 0.10 log 0.10 + 0.40 log 0.40)= 1.43为求出平均互信息量,需要先求出输入与输出各自的不确定度H(X) =- P(x.)log P(x.) =-(0.5log0.5 + 0.5log0.5) 1. =1H(Y) = -y P(y,)logP(y,) = -(0.59log0.59 + 0.41log0.41) =0.98.=1所以平均互信息为I(X; Y) = H(X) + H(Y) - H(XY) = 1+0.98-1.43=0.55而疑义度和噪声熵分别为H(XIY)=H(X)-I(X;Y)=1-0.55=0.45H(YIX)=H(Y)-I(X;Y)

8、=0.98-0.55=0.43至此,我们已经定义了熵H(x)、H(Y)、联合熵H(x,Y)、条件熵H(x I Y)、H (Y I X)和互信息I (X; Y),并讨论了它们的关系,为了进一步明确并便于记忆,可以用维恩(Venn)图示意如下:定理 2.2 条件作用使熵减小,即H(X I Y) 0H(X IY) H (X)。 例如审理案件时,根据足够的证据可以理清事 实,证据的作用是降低案件的不确定性,但是有可能控辩的某一方提 出了一个新证据,不仅没有减少案件的不确定性,反而使案件更加扑溯迷离。但是从平均意义上讲,下式总是成立的。H(X IY)=工 p(y)H(X IY 二 y) H(X)Y例2.

9、9设X,Y服从右图所示联合分布,计算X的分布是(3/4, 1/4),表 2-211 77H(X) = -log- - -log- = 0.54488 88H(X I y = 1) = 一p(x = 11 y = 1) log p(x = 11 y = 1) 一p(x = 21 y = 1) log(p(x = 21 y = 1)=0log0 一 1log1 = 0H (x1 y=2)=- ilogi - 2log2=H(X I Y) = p(y = 1)H(X I y = 1) + p(y = 2)H(X I y = 2)=3 x 0 +1 x 1 = 0.25比较这些结果发现,44H(X I

10、 y = 1) = 0 0.544 = H(X),即条件作用使熵增加了,但是平均结果是H(XIY)=0.250.544=H(X),即条件作用的平均结果使熵减少。2.1.6 相对熵 根据随机过程的知识,我们知道随机变量的取值具有一定的分 布特征,例如正态分布、瑞利分布,或者其它什么分布。通信编码时 要根据分布特征确定编码方案,以提高编码效率。例如,已知随机变 量的真实分布为p,我们就可以构造平均长度为H(p)的码来描述这个 随机变量。但是,如果我们使用的是针对分布q的编码,那么在平均 意义上,就需要在H (p)的基础上增加码长,否则不会取得良好的效果。 那么能否有一个定量的办法描述不同分布的差别

11、呢? 相对熵就是两个随机分布间距离的度量。定义2.8两个概率密度函数p(x)和q(Q之间的相对熵也叫库勒拜 克一雷伯勒(Kullback Leibler)距离,定义为D(p II q) = 丫 p(x)log( = e log(2-33)q( x)p q( x)X在上述定义中,基于连续性的假设,我们约定0log0 = 0和qp log = g0由于相对熵的定义可以写作D(p Il q)=yp( x)log p( x)-yp(x)logq(x)XX的形式,看起来像两个熵值的差,所以把它当做两个分布间的距离。不幸的是相对熵不满足对称性,也不满足一般距离应该满足的三 角不等式,所以虽然它具有非负特点

12、(下一章证明),实际上并不能 真正代表两个分布间的距离。然而,把它看作距离往往会有许多方便 之处。例2.10设X = 0,1,考虑X上的两个分布p和q。设p(0)= 1 -r,p(1) = r 及 q(0) = 1 - s, q(1) = s,贝廿有1 - rrD(p II q) = (1 - r)log+ rlog 1- ss1 - ssD(q II p) = (1 - s)log+ slog 1 - rr如果r = s,则D(p II q) = D(q II p) = 0。如果r = 1 ,s = 1,则可计算得到24D(p II q) = |l。于 + |l o34=1 -丄 l o 电

13、=0.2 0 7b5t)22 亠j.-2D(q II p) = -l of + 4I oif4 = 4I o3r 1 = 0.1 8 8b7t) 2 z2显然,一般情况下,d(p | q)丰D(q | p)。相对熵的概念使许多问题得到简化。下面,我们首先看一看相 对熵和平均互信息量的关系。两个随机变量X和Y的平均互信息是I(X; Y) = y P(xi, y .)1 (x.; y .)=工p(x, y)log p(: J) i j i jp( x)x.eXXYy( eY.y p(x, y) logXYp( x, y)p(x)p(y)= D(p(x, y) II p(x)p(y)(2-34)这就是说,平均互信息 I(X;Y) 就是联合分布 p(x,y) 与乘积分布 p(x)p(y)之间的相对熵。因此,式(2-34)也被看作平均互信息的另一种定义方式。有时我们可能遇到条件相对熵,这里仅给出其定义,不 做深入的讨论。定义 2.9 条件相对熵定义为D(p(y | x)| q(y | x)p(xp( y | x) logXYp (y I x)q(y|x) (2-35)

- 温馨提示:

1: 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

2: 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

3.本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

5. 装配图网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。