南开大学21秋《网络爬虫与信息提取》在线作业一答案参考92

南开大学21秋《网络爬虫与信息提取》在线作业一答案参考92

《南开大学21秋《网络爬虫与信息提取》在线作业一答案参考92》由会员分享,可在线阅读,更多相关《南开大学21秋《网络爬虫与信息提取》在线作业一答案参考92(13页珍藏版)》请在装配图网上搜索。

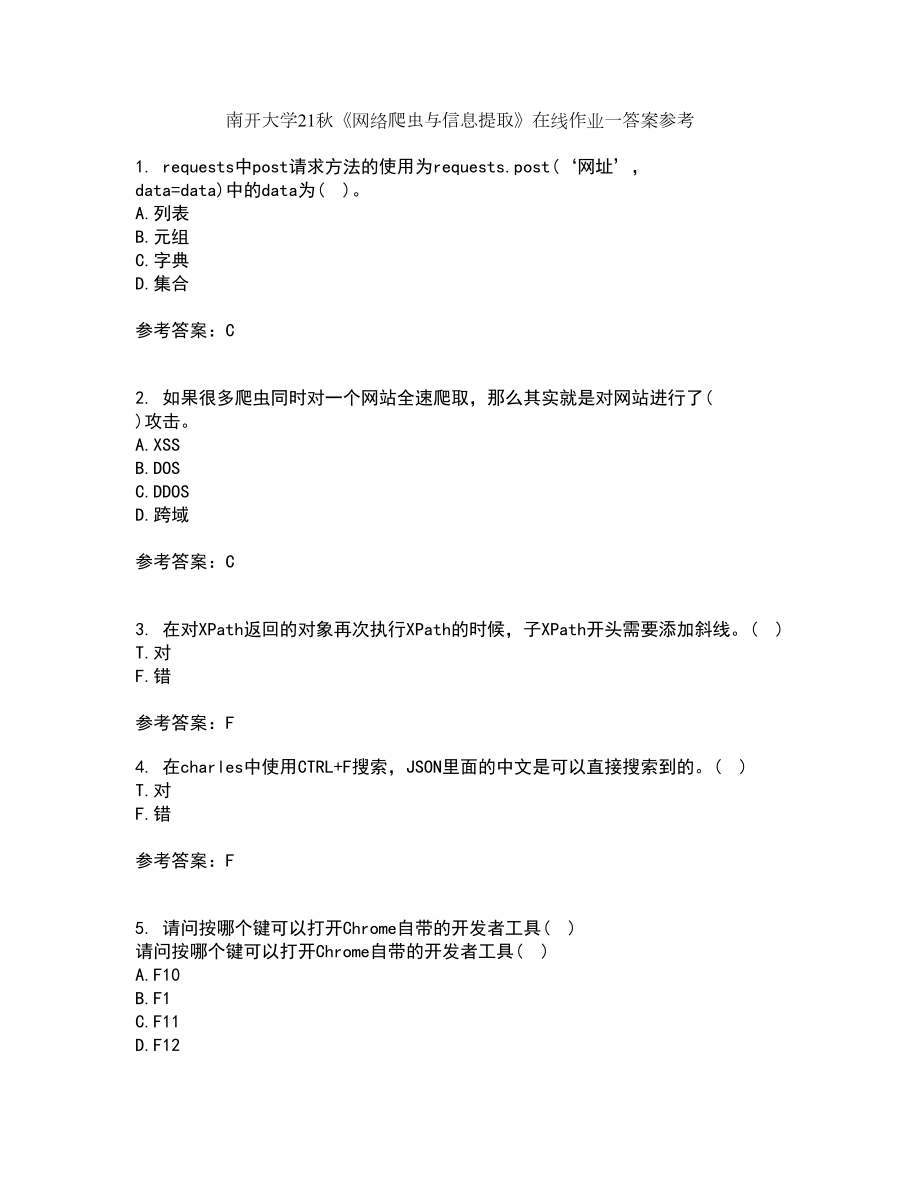

1、南开大学21秋网络爬虫与信息提取在线作业一答案参考1. requests中post请求方法的使用为requests.post(网址, data=data)中的data为( )。A.列表B.元组C.字典D.集合参考答案:C2. 如果很多爬虫同时对一个网站全速爬取,那么其实就是对网站进行了( )攻击。A.XSSB.DOSC.DDOSD.跨域参考答案:C3. 在对XPath返回的对象再次执行XPath的时候,子XPath开头需要添加斜线。( )T.对F.错参考答案:F4. 在charles中使用CTRL+F搜索,JSON里面的中文是可以直接搜索到的。( )T.对F.错参考答案:F5. 请问按哪个键可

2、以打开Chrome自带的开发者工具( )请问按哪个键可以打开Chrome自带的开发者工具( )A.F10B.F1C.F11D.F12参考答案:D6. 参数headers=( ),把请求头添加到Scrapy请求中,使爬虫的请求看起来像是从浏览器发起的。A.HEADERB.HEADERSC.HEADD.BODY参考答案:B7. PyMongo中逻辑查询表示小于的符号是( )A.$gtB.$ltC.$gte$lte参考答案:B8. 以下表示请求正常处理的HTTP状态码为( )以下表示请求正常处理的HTTP状态码为( )A.200B.301C.404D.500参考答案:A9. Python操作CSV文

3、件可通过( )容器的方式操作单元格。A.列表B.元组C.字典D.集合参考答案:C10. 当使用Scarpy创建爬虫时,当爬取网易云音乐首页信息时,scrapy genspider的第二个参数直接输入就可以了。( )当使用Scarpy创建爬虫时,当爬取网易云音乐首页信息时,scrapy genspider的第二个参数直接输入就可以了。( )A.正确B.错误参考答案:B11. 如果通过爬虫抓取某公司网站的公开数据,分析以后发现这个公司业绩非常好,于是买入该公司股票并赚了一笔钱。这是合法的。( )如果通过爬虫抓取某公司网站的公开数据,分析以后发现这个公司业绩非常好,于是买入该公司股票并赚了一笔钱。这

4、是合法的。( )A.正确B.错误参考答案:A12. 开源库pytesseract的作用是将图像中文字转换为文本。( )A.正确B.错误参考答案:A13. Python中把集合转换为列表需要使用( )函数。A.setB.listC.convertD.change参考答案:B14. Python中线程池map( )方法第二个参数是( )Python中线程池map( )方法第二个参数是( )A.列表B.元组C.字典D.集合参考答案:A15. 如果爬虫爬取的是商业网站,并且目标网站使用了反爬虫机制,那么强行突破反爬虫机制可能构成( )。A.非法侵入计算机系统罪B.非法获取计算机信息系统数据罪C.非法获

5、取计算机数据罪D.非法获取系统罪参考答案:AB16. Python中定义函数关键字为( )。A.defB.defineC.funcD.function参考答案:A17. 如果通过爬虫抓取某公司网站的公开数据,分析以后发现这个公司业绩非常好,于是买入该公司股票并赚了一笔钱。这是合法的。( )A.正确B.错误参考答案:A18. 虽然MongoDB相比于MySQL来说,速度快了很多,但是频繁读写MongoDB还是会严重拖慢程序的执行速度。( )T.对F.错参考答案:T19. 当Charles抓包以后,在Mac OS系统下可以按Command+F组合键,在Windows系统下按Ctrl+F组合键打开C

6、harles进行搜索。( )T.对F.错参考答案:T20. MongoDB支持对查询到的结果进行排序。排序的方法为sort( )。它的格式为:handler.find( ).sort(&39;列名&39;, 1或-1或0)。( )MongoDB支持对查询到的结果进行排序。排序的方法为sort( )。它的格式为:handler.find( ).sort(列名, 1或-1或0)。( )A.正确B.错误参考答案:B21. 采用以下( )技术可以实现异步加载A.HTMLB.AJAXC.CSSD.HTTP参考答案:B22. 下面Python代码输出为( ):def default_para_trap(p

7、ara=, value=0):para.append(value)return下面Python代码输出为( ):def default_para_trap(para=, value=0):para.append(value)return paraprint(第一步:.format(default_para_trap(value=100)print(第二步:.format(default_para_trap(value=50)A.第一步:100第二步:100,50B.第一步:100第二步:50C.第一步:100第二步:D.第一步:100第二步:100参考答案:A23. 爬虫的源代码通过公开不会对

8、被爬虫网站造成影响。( )A.正确B.错误参考答案:B24. HTTP状态码302表示资源永久重定向。( )T.对F.错参考答案:F25. Python中跳过本次循环应用关键字( )A.breakB.continueC.exitD.return参考答案:B26. Scrapy作为一个爬虫的框架,它在单机环境下运行时就可以获得最大性能优势。( )Scrapy作为一个爬虫的框架,它在单机环境下运行时就可以获得最大性能优势。( )A.正确B.错误参考答案:B27. 引用中间件时后面的数字代表的是中间件的执行顺序,例如 &39;AdvanceSpider.middlewares.ProxyMiddle

9、ware&39;: 543中的543。( )T.对F.错参考答案:T28. device.sleep( )方法是使用UI Automatorr关闭屏幕的命令。( )A.正确B.错误参考答案:A29. MongoDB中获取名字为db的库的语句为( )A.client.dbB.client(db)C.clientdbD.clientdb参考答案:AC30. 使用Nginx反向代理到Scrapyd以后,Scrapyd本身只需要开通内网访问即可,不许经过输入密码。( )A.正确B.错误参考答案:A31. Python并导入uiautomator来操作设备的语句是from uiautomator imp

10、ort( )。A.DeviceB.DevicesC.JobsD.Job参考答案:A32. Redis中从集合中查看有多少个值,用关键字( )。A.scardB.cardC.countD.distinct参考答案:A33. Scrapy_redis是Scrapy的“( )”,它已经封装了使用Scrapy操作Redis的各个方法。Scrapy_redis是Scrapy的“( )”,它已经封装了使用Scrapy操作Redis的各个方法。A.组件B.模块C.控件D.单元参考答案:A34. 以下哪个HTML标签表示定义 HTML 表格中的行( )以下哪个HTML标签表示定义 HTML 表格中的行( )A

11、.B.C.D.参考答案:C35. process_spider_input(response,spider)是在爬虫运行yield item或者yield scrapy.Request( )的时候调用。( )A.正确B.错误参考答案:B36. 爬虫中间件的作用对象是请求request和返回response。( )爬虫中间件的作用对象是请求request和返回response。( )A.正确B.错误参考答案:B37. robots.txt是一种规范,在法律范畴内。( )robots.txt是一种规范,在法律范畴内。( )A.正确B.错误参考答案:B38. Python中把列表转换为集合需要使用(

12、 )函数。A.setB.listC.convertD.change参考答案:A39. PyMongo更新操作有( )。A.updateB.update_allC.update_oneD.update_many参考答案:CD40. 以下哪些方法属于Python写CSV文件的方法?( )A.writeheadersB.writeheaderC.writerrowsD.writerow参考答案:ACD41. 在中间人攻击中,攻击者可以拦截通信双方的通话,并插入新的内容或者修改原有内容。( )在中间人攻击中,攻击者可以拦截通信双方的通话,并插入新的内容或者修改原有内容。( )A.正确B.错误参考答案:

13、A42. 使用异步加载技术的网站,被加载的内容可以在源代码中找到。( )T.对F.错参考答案:F43. 使用xpath方法的返回类型是( )。A.列表B.元组C.字典D.集合参考答案:A44. 在使用多线程处理问题时,线程池设置越大越好。( )A.正确B.错误参考答案:B45. Redis插入数据都是插入到列表右侧,因此读取数据也是从右侧读取。( )T.对F.错参考答案:F46. 常用的会话跟踪技术是( )A.sessionB.cookiesC.moonpiesD.localstorage参考答案:AB47. Redis中列表读取数据命令lrange中l代表left,即从左侧开始读取。( )R

14、edis中列表读取数据命令lrange中l代表left,即从左侧开始读取。( )A.正确B.错误参考答案:B48. 插入数据时,MongoDB会自动添加一列“_id”,也就是自增ID,每次自动加1。( )T.对F.错参考答案:F49. Python中( )与元组由类似的数据读取方式。A.字符串B.列表C.字典D.集合参考答案:AB50. scrapy与selenium结合可以实现直接处理需要异步加载的页面。( )T.对F.错参考答案:T51. Python中( )容器有推导式Python中( )容器有推导式A.列表B.元组C.字典D.集合参考答案:ACD52. Charles和Chrome开发

15、者工具相比,只是多了一个搜索功能。( )A.正确B.错误参考答案:B53. BS4可以用来从( )中提取数据。BS4可以用来从( )中提取数据。A.HTMLB.XMLC.数据库D.JSON参考答案:AB54. XPath提取出来的内容是一个SelectorList对象,它的第0个元素就是网页的源代码。( )T.对F.错参考答案:F55. 通用搜索引擎的目标是尽可能大的网络覆盖率,搜索引擎服务器资源与网络数据资源互相匹配。( )A.正确B.错误参考答案:B56. 在请求头中设置User-Agent即可正常请求网站。( )在请求头中设置User-Agent即可正常请求网站。( )A.正确B.错误参

16、考答案:B57. 使用python定制mitmproxy,下面的语句请求的是( )。req.headersUser-AgentA.headersB.文本内容C.目标网站D.user-agent参考答案:D58. 安装mitmdump之前,运行sudo apt-get install python3-dev python3-pip libffi-dev libssl-dev是为了安装必要的运行环境。( )T.对F.错参考答案:T59. 使用UI Automatorr让屏幕向右滚动的操作是得到相应控件后使用命令scroll.horiz.forward( )。( )T.对F.错参考答案:F60. 中间人爬虫就是利用了中间人攻击的原理来实现数据抓取的一种爬虫技术。( )A.正确B.错误参考答案:A

- 温馨提示:

1: 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

2: 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

3.本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

5. 装配图网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。