数据挖掘题目及答案(共7页)

数据挖掘题目及答案(共7页)

《数据挖掘题目及答案(共7页)》由会员分享,可在线阅读,更多相关《数据挖掘题目及答案(共7页)(7页珍藏版)》请在装配图网上搜索。

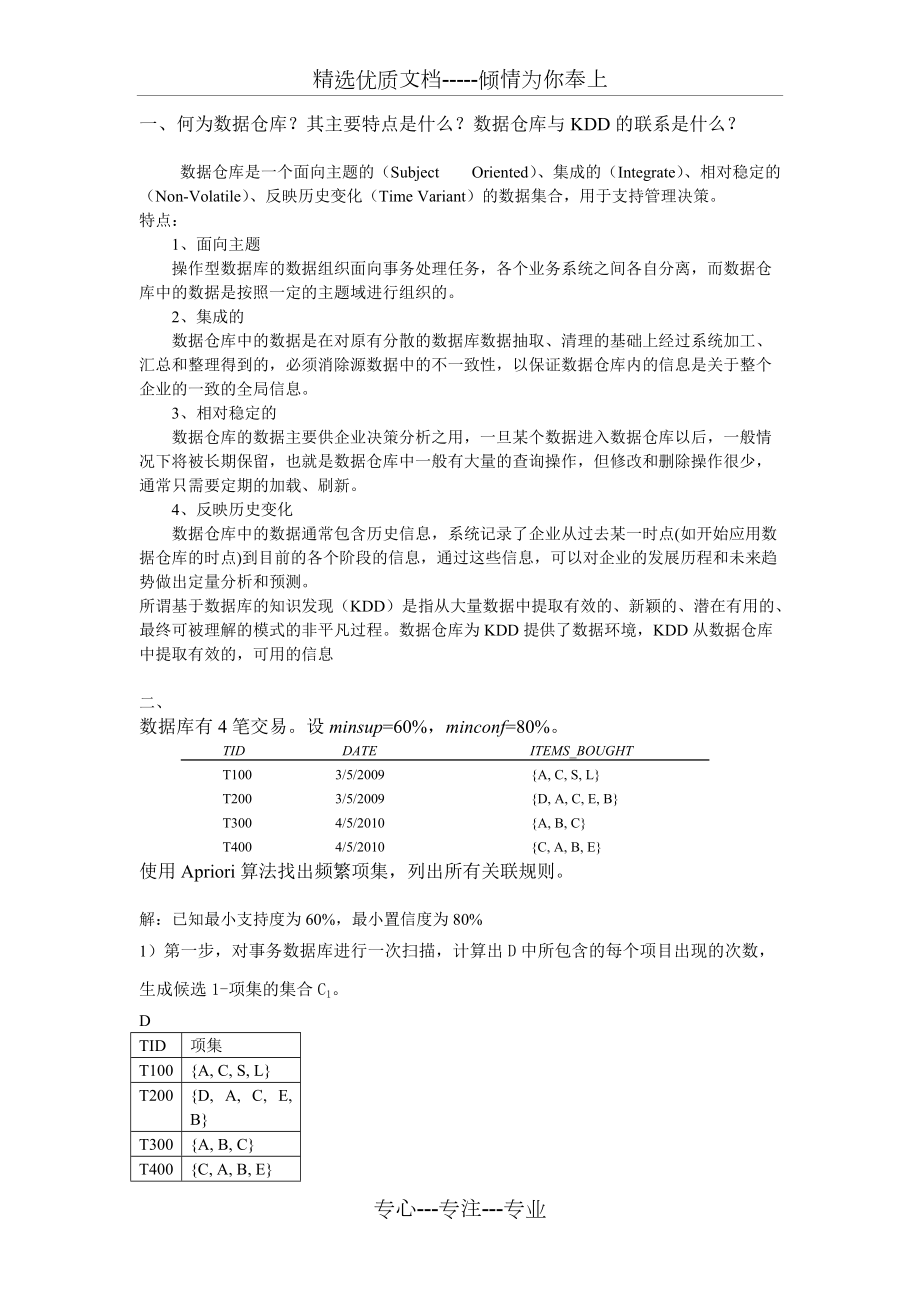

1、精选优质文档-倾情为你奉上一、何为数据仓库?其主要特点是什么?数据仓库与KDD的联系是什么?数据仓库是一个面向主题的(Subject Oriented)、集成的(Integrate)、相对稳定的(Non-Volatile)、反映历史变化(Time Variant)的数据集合,用于支持管理决策。特点:1、面向主题 操作型数据库的数据组织面向事务处理任务,各个业务系统之间各自分离,而数据仓库中的数据是按照一定的主题域进行组织的。 2、集成的 数据仓库中的数据是在对原有分散的数据库数据抽取、清理的基础上经过系统加工、汇总和整理得到的,必须消除源数据中的不一致性,以保证数据仓库内的信息是关于整个企业的

2、一致的全局信息。 3、相对稳定的 数据仓库的数据主要供企业决策分析之用,一旦某个数据进入数据仓库以后,一般情况下将被长期保留,也就是数据仓库中一般有大量的查询操作,但修改和删除操作很少,通常只需要定期的加载、刷新。 4、反映历史变化 数据仓库中的数据通常包含历史信息,系统记录了企业从过去某一时点(如开始应用数据仓库的时点)到目前的各个阶段的信息,通过这些信息,可以对企业的发展历程和未来趋势做出定量分析和预测。所谓基于数据库的知识发现(KDD)是指从大量数据中提取有效的、新颖的、潜在有用的、最终可被理解的模式的非平凡过程。数据仓库为KDD提供了数据环境,KDD从数据仓库中提取有效的,可用的信息二

3、、数据库有4笔交易。设minsup=60%,minconf=80%。 TID DATE ITEMS_BOUGHT T100 3/5/2009 A, C, S, L T200 3/5/2009 D, A, C, E, B T300 4/5/2010 A, B, C T400 4/5/2010 C, A, B, E使用Apriori算法找出频繁项集,列出所有关联规则。解:已知最小支持度为60%,最小置信度为80%1)第一步,对事务数据库进行一次扫描,计算出D中所包含的每个项目出现的次数,生成候选1-项集的集合C1。DTID项集T100A, C, S, LT200D, A, C, E, BT300A

4、, B, CT400C, A, B, EC1项集支持度计数A4B3C4D1E2S1L12)第二步,根据设定的最小支持度,从C1中确定频繁1-项集L1。L1项集支持度计数A4B3C43)第三步,由L1产生候选2-项集C2,然后扫描事务数据库对C2中的项集进行计数。C2项集支持度计数A, B3A, C4B, C34) 第四步,根据最小支持度,从候选集C2中确定频繁2-项集L2。L2项集支持度计数A, B3A, C4B, C35)第五步,由频繁2-项集L2生成候选3-项集C3,生成的候选3-项集的集合C3=A,B,C,C3的子集都是频繁的,且项集A,B,C计数为3,即L3=C3=A,B,C,L3即为

5、频繁3-项集。由频繁项集产生关联规则如下:针对频繁3-项集L3,非空真子集有:A,B,C,A,B,A,C,B,C,相应的置信度为:规则置信度A-B&C3/4=75%B-A&C3/3=100%C-A&B3/4=75%A&B-C3/3=100%A&C-B3/4=75%B&C-A3/3=100%因为最小置信度为90%,故所有关联规则为:B-A&C、A&B-C、B&C-A三、假设数据集D含有9个数据对象(用二维空间的点表示):A1(3, 2),A2(3, 9),A3(8, 6),B1(9, 5),B2(2, 4),B3(3, 10),C1(2, 6),C2(9, 6),C3(2, 2)基于欧几里得距离

6、采用k-均值方法聚类,取k=3,初始的簇质心为A1,B1和C1,求:(1) 第一次循环结束时的三个簇的质心。(2) 最后求得的三个簇。解:(1)第一次循环:d2(A1,A1)=(3-3)2+(2-2)2=0d2(A1,B1)=(3-9)2+(2-5)2=45d2(A1,C1)=(3-2)2+(2-6)2=17因为d2(A1,A1)最小,所以,A1-A1d2(A2,A1)=(3-3)2+(9-2)2=49d2(A2,B1)=(3-9)2+(9-5)2=60d2(A2,C1)=(3-2)2+(9-6)2=10因为d2(A2,C1)最小,所以,A2-C1d2(A3,A1)=(8-3)2+(6-2)2

7、=41d2(A3,B1)=(8-9)2+(6-5)2=2d2(A3,C1)=(8-2)2+(6-6)2=36因为d2(A3,B1)最小,所以,A3-B1d2(B1,A1)=(9-3)2+(5-2)2=45d2(B1,B1)=(9-9)2+(5-5)2=0d2(B1,C1)=(9-2)2+(5-6)2=50因为d2(B1,B1)最小,所以,B1-B1d2(B2,A1)=(2-3)2+(4-2)2=5d2(B2,B1)=(2-9)2+(4-5)2=50d2(B2,C1)=(2-2)2+(4-6)2=4因为d2(B2,C1)最小,所以,B2-C1d2(B3,A1)=(3-3)2+(10-2)2=64

8、d2(B3,B1)=(3-9)2+(10-5)2=61d2(B3,C1)=(3-2)2+(10-6)2=17因为d2(B3,C1)最小,所以,B3-C1d2(C1,A1)=(2-3)2+(6-2)2=17d2(C1,B1)=(2-9)2+(6-5)2=50d2(C1,C1)=(2-2)2+(6-6)2=0因为d2(C1,C1)最小,所以,C1-C1d2(C2,A1)=(9-3)2+(6-2)2=50d2(C2,B1)=(9-9)2+(6-5)2=1d2(C2,C1)=(9-2)2+(6-6)2=49因为d2(C2,B1)最小,所以,C2-B1d2(C3,A1)=(2-3)2+(2-2)2=1d

9、2(C3,B1)=(2-9)2+(2-5)2=58d2(C3,C1)=(2-2)2+(2-6)2=16因为d2(C3,A1)最小,所以,C3-A1所以第一次循环结束时,第一类:A1,C3,质心为O1(2.5, 2)第二类:B1,A3,C2, 质心为O2(9, 5.67)第三类:C1,A2,B2,B3, 质心为O3(2.5, 7.25)(2) 第二次循环结束时,第一类:A1,B2,C3,质心为O1(2.33,3),第二类:A3,B1,C2,质心为O2(8.67,5.67),第三类:A2,B3,C1,质心为O3(2.67,8.33)。第三次循环结束时,第一类:A1,B2,C3,质心为O1(2.33

10、,3),第二类:A3,B1,C2,质心为O2(8.67,5.67),第三类:A2,B3,C1,质心为O3(2.67,8.33)。结果与第二次循环结束的结果一样,故最后求得的结果为:第一类:A1,B2,C3,质心为O1(2.33,3),第二类:A3,B1,C2,质心为O2(8.67,5.67),第三类:A2,B3,C1,质心为O3(2.67,8.33)。四、给定数据集S,试根据前7个样本构造ID3决策树模型,并预测第8个样本的类别?数据集SSampleABCS1a0b0c1S2a0b1c1S3a0b2c1S4a1b0c2S5a1b1c1S6a1b2c2S7a2b0c2S8a2b1解:现计算每个属

11、性的信息增益。对给定样本分类所需的期望信息为:E(S)= (3/7)log2 (3/7)(4/7)log2 (4/7)=0.5239+0.4613=0.9852Values(A)=a0, a1, a2, Sa0 =S1, S2, S3,Sa0=3,其中3个都属于类C1,故有: E(Sa0)= (5/5)log2(5/5) (0/5)log2(0/5)=0 Sa1= S4, S5, S6,Sa1=3,其中,1个属于c1,2个属于c2,故有E(Sa1)= (1/3)log2(1/3) (2/3)log2(2/3)=0.5283+0.3900=0.9183同理,E(Sa2)= (1/1)log2(1

12、/1)(0/1)log2(0/1)=0 因此属性A的期望熵为:E(S,A)=(3/7)E(Sa0)+ (3/7)E(Sa1)+(1/7)E(Sa2)=0.3936 故A的信息增益为:Gain(S, A)= E(S) E(S, A) =0. 9852 0. 3936=0.5916 同理:Values(B)=b0, b1, b2, Sb0 =S1, S4, S7,Sb0=3,其中,1个属于c1,2个属于c2,故有E(Sb0)= (1/3)log2(1/3) (2/3)log2(2/3)=0.5283+0.3900=0.9183Sb1= S2, S5,Sb1=2,其中2个都属于类C1, 故有E(Sb

13、1)= (2/2)log2(2/2) (0/2)log2(0/2)=0 同理,E(Sb2)= (1/2)log2(1/2) (1/2)log2(1/2)=1 因此属性B的期望熵为:E(S, B)=(3/7)E(Sb0)+ (2/7)E(Sb1)+(2/7)E(Sb2)=0.3936+0+0.2857=0.6793 故B的信息增益为:Gain(S,B)= E(S) E(S, B) =0. 98520. 6793 =0.3059 故A的信息增益最大,令属性A为根节点的测试属性,并对应每个值(a0,a1,a2)在根节点下建立分支,形成部分决策树:Aa0a1 a2S7S4,S5,S6S1,S2,S3对

14、于A=a0和A=a2节点,它们对应的属性唯一,不需进一步讨论,而对于A=a1节点,需要进一步讨论。由于只有B属性可供讨论,因此依据不同的取值,可得最终的决策树:Aa0a1 a2c2c1Bc2c1c2b0 b1 b2 根据以上决策树,可知第8个样本S8的类别为c2.五、设论域U=x1, x2 , x6,属性集A=CD,条件属性集C=a, b, c,决策属性集D=d,决策表如下:决策表abcdx11021x21021x31202x41220x52102x62112问:决策表是否为一致决策表?利用分辨矩阵对决策表进行约简。解:由决策表可知,U/C=x1, x2, x3, x4, x5, x6U/D=x1, x2, x3, x5, x6, x4POSC(D)=x1, x2, x3, x4, x5, x6因为k=| POSC(D)|/|U|=1,故该决策表为一致决策表。该决策表的分辨矩阵为6阶方阵,其元素为123456123b,cb,c4bbc5a,b,ca,b,ca,b,c6a,b,ca,b,ca,b,c所以决策表的分辨函数为:=(bc)(bc)(b)(b)(c)(abc)(abc)(abc)(abc)(abc)(abc)=bc故C的D约简为b,c,C的D核为b,c,约简的决策表为:Ubcdx1021x2021x3202x4220x5102x6112专心-专注-专业

- 温馨提示:

1: 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

2: 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

3.本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

5. 装配图网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。