ML中的过拟合问题

ML中的过拟合问题

《ML中的过拟合问题》由会员分享,可在线阅读,更多相关《ML中的过拟合问题(5页珍藏版)》请在装配图网上搜索。

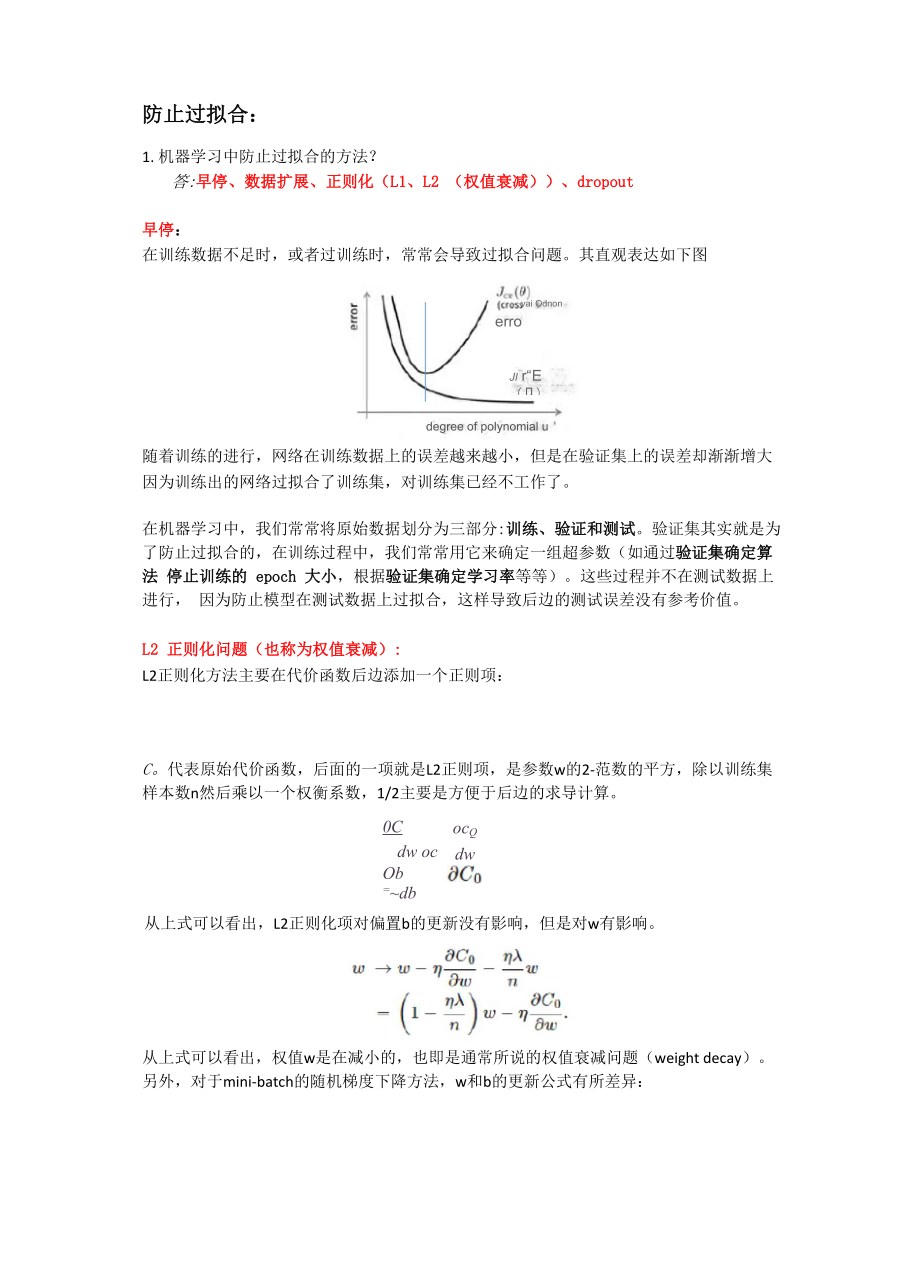

1、防止过拟合:1. 机器学习中防止过拟合的方法?答:早停、数据扩展、正则化(L1、L2 (权值衰减)、dropout早停:在训练数据不足时,或者过训练时,常常会导致过拟合问题。其直观表达如下图Jl r“E (卩)trininig errdr)degree of polynomial uvai Odnonerrorl随着训练的进行,网络在训练数据上的误差越来越小,但是在验证集上的误差却渐渐增大因为训练出的网络过拟合了训练集,对训练集已经不工作了。在机器学习中,我们常常将原始数据划分为三部分:训练、验证和测试。验证集其实就是为 了防止过拟合的,在训练过程中,我们常常用它来确定一组超参数(如通过验证集

2、确定算法 停止训练的 epoch 大小,根据验证集确定学习率等等)。这些过程并不在测试数据上进行, 因为防止模型在测试数据上过拟合,这样导致后边的测试误差没有参考价值。L2 正则化问题(也称为权值衰减):L2正则化方法主要在代价函数后边添加一个正则项:C。代表原始代价函数,后面的一项就是L2正则项,是参数w的2-范数的平方,除以训练集 样本数n然后乘以一个权衡系数,1/2主要是方便于后边的求导计算。ocQdw0Cdw ocOb =db从上式可以看出,L2正则化项对偏置b的更新没有影响,但是对w有影响。从上式可以看出,权值w是在减小的,也即是通常所说的权值衰减问题(weight decay)。

3、另外,对于mini-batch的随机梯度下降方法,w和b的更新公式有所差异:m 表示一个 mini-batch 中的样本数目 Cx 表示第 x 个 batch 的代价函数。L2 正则化方法之所以可以防止过拟合,是因为模型的参数越小,复杂度就越小,对数据的 拟合也就刚刚好。L1 正则化:在原始的代价函数后边加上一个L1的正则项,即是权值w的绝对值之和,乘以lamda/n求导之后:上式中的sng(w)表示w的符号,那么权值w的更新公式为:当w为正时,w减小,为负时,w增大。这样就使得w往0方向移动,也就相当于减小了 网络的复杂度,防止过拟合。Drop-out 方法:L1和L2正则化方法是通过修改代

4、价函数来实现,而Drop-out则是通过修改神经网络本身来 实现,它是训练网络时的一种技巧。在深度学习网络训练中,对于神经单元而言, 按照一定的概率将其暂时从网络中丢弃。对 于 SGD 方法,由于是随机丢弃,故而每一个 mini-batch 都在训练不同的网络。每一个网络 都可以给出一个分类结果,有的正确,有的错误,随着训练的进行,大部分网络可以给出正 确的分类结果,但是不会影响到整体的分类结果。对于大规模神经网络而言,存在两个缺点:训练费时和容易过拟合每次做完Drop-out,相当于从原始网络中找到一个更瘦的网络。00 假如在每一次的迭代中,丢弃网络中半数的隐层神经元,得到一个半数网络。那么

5、在若干次 的迭代中,得到若干个半数网络,当然每一次的迭代所丢弃的神经元是不一样的。数据扩展: 因为训练数据中的带标记数据收集比较困难,我们为了获取更多的训练数据,可以在原始数 据上做改动,从而得到更多数据。如: 添加随机噪声 平移、旋转、缩放、翻转 截取原始图像中的一部分 颜色变换样本偏斜问题:样本偏斜也叫做数据集偏斜(unbalanced),它是指参与分类的两个类别之间的训练样本数目差异较大。如正类有10,000 个样本,负类有 100 个,则会导致样本偏斜问题。类别不平衡是指在分类任务中,不同类别的训练样本数目差别很大的情况。现有的应对样本倾斜问题的方法有三种:对数目较多的一类采用欠采样方

6、法。即是去除一 些多余的样本,使得样本平衡,然后再进行学习;第二类方法即是对样本数目少的一类采用 过采样的方法,即是增加一些样本,然后再进行学习;第三类方法则是直接基于原始训练集 进行学习,但是在用训练好的分类器上预测时,利用上式做决策,称为阈值移动。欠采样并不是简单的去除样本,可能会导致重要信息丢失,有效的方法为 EasyEnsemble 。 主要思想在于利用集成学习机制,将多数样本类划分为多个部分,供多个学习器使用,这样 相当于对每一个学习器都进行了欠采样,对于整体而言,并不会丢失重要信息。过采样不能简单的对初始正样本进行重复采样,否则会招致严重的过拟合,过采样代表性方 法为SMOTE,即

7、是通过对训练数据里的少量样本进行插值产生额外的样本。再缩放方法:对于线性分类问题而言,通常利用预测值y与阈值进行比较,y0.5则认为正 类,反之为负类,y其实表示的是属于正样本的可能性,t= y/1-y表示的即是几率。通常认 为 t1 为正类,反之为负类。这种判别方法适用于正样本和负样本数目差不多时。但是当两 类差别较大时,通常是通过t和观测几率进行比较。即是t= y/1-y m+/m-,m+和m-分别表 示正负样本数。基于前者和后者,对预测几率进行调整,得到:1-厂L-# 帼1这就是类别不平衡的一种基本策略 再缩放或再平衡。再缩放的思想是建立在训练集是整 体样本的无偏采样,但是这个假设并不一

8、定成立,即是未必能够推断出真实的观测几率。1)实现参数的稀疏有什么好处吗?一个好处是可以简化模型,避免过拟合。因为一个模型中真正重要的参数可能并不多,如 果考虑所有的参数起作用,那么可以对训练数据可以预测的很好,但是对测试数据就只能呵 呵了。另一个好处是参数变少可以使整个模型获得更好的可解释性。2)参数值越小代表模型越简单吗?是的。为什么参数越小,说明模型越简单呢,这是因为越复杂的模型,越是会尝试对所有的 样本进行拟合,甚至包括一些异常样本点,这就容易造成在较小的区间里预测值产生较大的 波动,这种较大的波动也反映了在这个区间里的导数很大,而只有较大的参数值才能产生较 大的导数。因此复杂的模型,

9、其参数值会比较大。L0正则化表示的是非零元素的数目;(NP-难题)L1正则化在实际中往往替代L0正则化,来防止过拟合,在江湖中也人称Lasso;L2正则化江湖人称Ridge,也称“岭回归”。L1会趋向于产生少量的特征,而其他的特征都是0而L2会选择更多的特征,这些特征都 会接近于0。Lasso在特征选择时候非常有用,而Ridge就只是一种规则化而已。在所有特 征中只有少数特征起重要作用的情况下,选择Lasso比较合适,因为它能自动选择特征。 而如果所有特征中,大部分特征都能起作用,而且起的作用很平均,那么使用Ridge也许 更合适。我们大概知道了 L1可以实现稀疏,但我们会想呀,为什么要稀疏?

10、让我们的参数稀疏 有什么好处呢?这里扯两点:1)特征选择(Feature Selection):大家对稀疏规则化趋之若鹫的一个关键原因在于它能实现特征的自动选择。一般来说, xi的大部分元素(也就是特征)都是和最终的输出yi没有关系或者不提供任何信息的,在最 小化目标函数的时候考虑xi这些额外的特征,虽然可以获得更小的训练误差,但在预测新 的样本时,这些没用的信息反而会被考虑,从而干扰了对正确yi的预测。稀疏规则化算子 的引入就是为了完成特征自动选择的光荣使命,它会学习地去掉这些没有信息的特征,也就 是把这些特征对应的权重置为0。2)可解释性(Interpretability):另一个青睐于稀

11、疏的理由是,模型更容易解释。例如患某种病的概率是y,然后我们收 集到的数据x是1000维的,也就是我们需要寻找这1000种因素到底是怎么影响患上这种 病的概率的。假设我们这个是个回归模型:y=w1 *X+w2*x2+w 1000*x1000+b (当然了,为 了让y限定在0,1的范围,一般还得加个Logistic函数)。通过学习,如果最后学习到的 w*就只有很少的非零元素,例如只有5个非零的wi,那么我们就有理由相信,这些对应的 特征在患病分析上面提供的信息是巨大的,决策性的。也就是说,患不患这种病只和这5 个因素有关,那医生就好分析多了。但如果1000个wi都非0,医生面对这1000种因素, 累觉不爱。

- 温馨提示:

1: 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

2: 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

3.本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

5. 装配图网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。