单词和短语的分布式表示和他们的组合性

单词和短语的分布式表示和他们的组合性

《单词和短语的分布式表示和他们的组合性》由会员分享,可在线阅读,更多相关《单词和短语的分布式表示和他们的组合性(8页珍藏版)》请在装配图网上搜索。

1、单词和短语的分布式表示和他们的组合性文摘最近推出的Skip-gram模型是一种有效的方法来学习高品质的分布式向量表示,它捕捉了大量num-ber精确的语法和语义词的关系和方法。在本文中我们提出几个扩展,提高质量的向量和训练速度。通过频繁的二次抽样,使我们的学习得到显著加速同时也学更多的定期字表示。我们还描述了一个简单的alterna-tive层次,softmax称为负采样。词表示有着特定的局限性,他们无法代表习惯用语。例如,“加拿大”和“空气”不能容易地组合以获得“加拿大航空公司,通过这个例子中,我们提出了用于查找文本短语的简单方法,这个便使得学习良好的向量表示和为数百万短语成为可能。1引言在

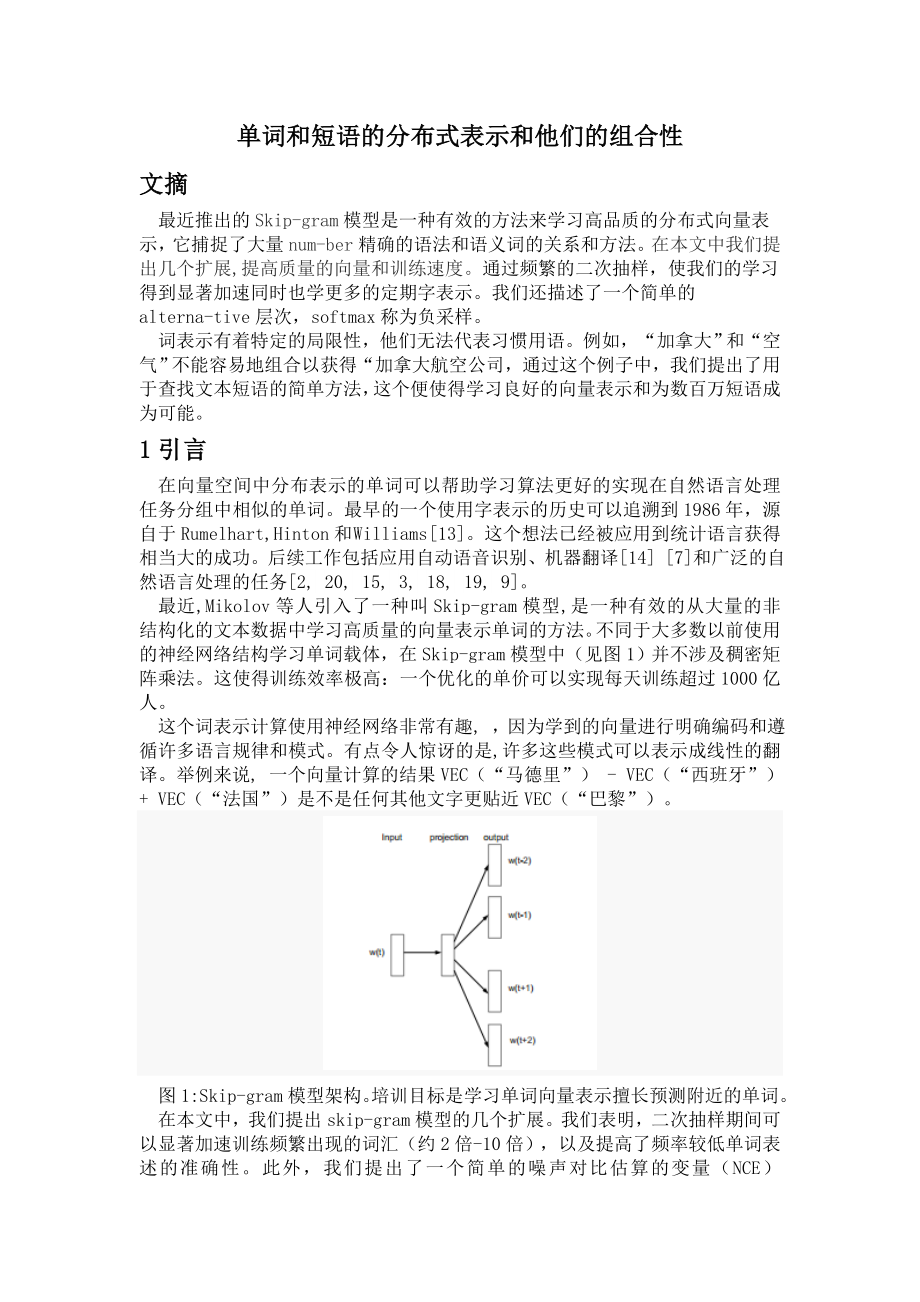

2、向量空间中分布表示的单词可以帮助学习算法更好的实现在自然语言处理任务分组中相似的单词。最早的一个使用字表示的历史可以追溯到1986年,源自于Rumelhart,Hinton和 Williams 13。这个想法已经被应用到统计语言获得相当大的成功。后续工作包括应用自动语音识别、机器翻译14 7和广泛的自然语言处理的任务2, 20, 15, 3, 18, 19, 9。最近,Mikolov等人引入了一种叫Skip-gram模型,是一种有效的从大量的非结构化的文本数据中学习高质量的向量表示单词的方法。不同于大多数以前使用的神经网络结构学习单词载体,在Skip-gram模型中(见图1)并不涉及稠密矩阵乘

3、法。这使得训练效率极高:一个优化的单价可以实现每天训练超过1000亿人。这个词表示计算使用神经网络非常有趣, ,因为学到的向量进行明确编码和遵循许多语言规律和模式。有点令人惊讶的是,许多这些模式可以表示成线性的翻译。举例来说, 一个向量计算的结果VEC(“马德里”) - VEC(“西班牙”)+ VEC(“法国”)是不是任何其他文字更贴近VEC(“巴黎”)。图1:Skip-gram模型架构。培训目标是学习单词向量表示擅长预测附近的单词。在本文中,我们提出skip-gram模型的几个扩展。我们表明,二次抽样期间可以显著加速训练频繁出现的词汇(约2倍- 10倍),以及提高了频率较低单词表述的准确性。

4、此外,我们提出了一个简单的噪声对比估算的变量(NCE)4skip-gram模型导致更快的培训和频繁出现的词汇更好的向量表示,SOFTMAX分层相比于这个更复杂8。受限于词表示他们无法使惯用短语成分个别单词。例如,“波士顿环球报”是一个报纸,所以它不是一个自然的组合的含义“波士顿”和“全球”。 因此,使用向量repre-sent整个短语比Skip-gram模型表达得多。其他技术,主要在的句子通过组合这个词向量,如递归来表示句子2的含义15,也将受益于使用短语向量代替这个词向量。从文字扩展为基础,以基于短语的模型比较简单。首先我们确定一个大的采用数据驱动的方法短语号码,然后我们对待短语作为单独的标

5、记。在培训期间。为了评估这句话向量质量,我们开发了一个用于类比同时包含单词和短语推理任务的测试器。从我们的测试中看到一个典型的比喻是对“蒙特利尔”:“蒙特利尔加拿大人”:“多伦多”:“多伦多枫叶”。如果最近表示它会被认为是已经正确回答,以VEC(“蒙特利尔加拿大人”) - VEC(“蒙特利尔”)+VEC(“多伦多”)VEC(“多伦多枫叶”)。最后,我们描述了跳过-gram模型的另一个有趣的特性。我们发现,简单向量加法往往能产生有意义的结果。例如,VEC(“俄罗斯”)+ VEC(“河”)是接近VEC(“伏尔加河”),和VEC(“德国”)+ VEC(“资本”)接近VEC(“柏林”)。 这个组合性暗

6、示的语言理解非常显而易见可以通过获得使用上的字向量表示基本的数学运算。2 Skip-gram模型skip-gram模型的训练目标用字表示是获取在一个句子或文档周围的的用词。更正式地说,由于序列训练单词w1,W2,W3,。 。 。 ,WT,skip-gram模型的目标是最大化的平均数概率。 (1)其中c是训练上下文(其可以是中心单词重量的函数)的大小。在训练时间为代价的前提下,更多的训练示例并因此较大C结果可导致更高的精度。基本Skip-gram公式定义了p(wt + j | wt)将要使用softmax函数: (2)其中,vw和vw是“输入”和“输出”向量表示,W是数在词汇。这种提取的方法是不

7、切实际的,因为计算成本和logP(WO| WI)是成正比的,这往往是(105-107项)。2.1 Softmax分层SOFTMAX的计算效率近似于分层SOFTMAX。 神经网络语言模型最早是由莫兰和Bengio12提出。该主要优点是代替在神经网络中评估W的输出节点,以获得概率分布,则需要评估仅约LOG2(W)的节点。分层SOFTMAX使用输出层的二进制树表示用W字作为其叶子和,对于每个节点,明确地表示它的子节点的相对概率。 这些定义分配概率的话便可以随机游走。更精确地说,每一个字,我们也可以从树的根的适当路径到达。设n(重量,j)的是从根为w的路径上的第j个节点,并设L(w)的是该路径的长度,

8、因此n(重量,1)=根和n(W,L(W)=瓦特此外,对于任何内部节点n,让通道(n)是n的任意的固定子和如果x为真,否则返回-1让X为1。然后分层SOFTMAX限定P(WO| WI)如下: (3)在(x)= 1 /(1 + exp(x)。它可以证实这意味着成本计算logp(我们| wI)和logp(我们| wI)L成正比(我们),平均值不大于W。也不像的标准softmax方法和Skip-gram分配两个表示vw每个单词和vw w,层次softmax配方对每个词都有一个表示vw和一个表示vn为每个内部节点n的二叉树。由于分级SOFTMAX使用的树结构对性能有很大影响,所以Mnih和辛顿探索了许多

9、方法用于构造的树结构并同时在训练时间的效果和所产生的模型精度的方法10。在我们的工作中,我们使用二进制哈夫曼树,因为它能够分配短代码而导致快速训练。在此之前,利用分组的话可以通过频率工作以及用于基于神经网络的语言模型把一个非常简单的加速技术放到到一起5,8。2.2 负抽样分层SOFTMAX的一种替代是噪声对比估计模型(NCE),这是由古特曼和许韦里宁4引入并通过Mnih和德施加到语言模型11.NCE假定,一个好的模型应该能够从区分数据逻辑回归方式的噪音。这有点像由Collobert和韦斯顿2使用的损耗谁由排名高于噪声的数据训练的模型。指标可以显示softmax的对数概率最大化,Skip-gra

10、m模型只关心学习质量的向量表示,所以只要我们利用定义消极抽样(否定)的目标可以简化指标向量表示保留它们的质量 (4)利用主成分分析法(PCA)和资本向量投影的国家图2:二维主要分析的投影Skip-gram向量的国家及其首都城市。下图说明了模型的能力,自动组织观念和学习含蓄它们之间的关系,因为在训练期间,我们没有提供关于任何受监管的信息一个省会城市的意思。用于替换每个日志Skip-gram P(我们| wI)项目标。因此,任务是区分目标词我们从噪声分布吸引Pn(w)使用逻辑回归的,哪里有k负样本为每个数据样本。我们的实验表明,k值范围在5 - 20是有用的为小型训练数据集,而对于大型数据集可以小

11、至2 - 5 k。负采样和出版社之间的主要区别是,一旦需要这样的人样本和噪声的数值概率分布,而负采样只使用样品。虽然出版社约日志将softmax概率最大化,但是这个属性对应用程序并不重要NCE和NEG把负的噪声分布Pn(w)作为一个自由参数。我们调查了一些对的Pn选择(重量),并发现该单字组分布U(w)的上升到3 /4RD功率(即,U(W)3/4 / Z)显著优于单字组和均匀分布,为NCE和NEG上的每一项任务,我们尝试包括语言模型(这里不报道)。2.3频繁的二次抽样在非常大的语料库中,最频繁的字可以很容易地出现数亿倍(例如,“在”,“该”,和“一个”)。这样的话通常提供比生僻字信息的价值少。

12、 对于这样的情况,,Skip-gram模型可以观察“法国”、“巴黎”,它从观察频繁的出现“法国”、“的”,几乎每一个词经常在一个句子都存与“的”。 这种想法也可应用于在相反的方向,频繁的二次抽样可以改变几百万的实训例子。为了应对罕见的频繁的词与词之间的不平衡,我们用一个简单的二次抽样的方法,就是用每个字被丢弃的概率由公式来计算 (5) 表1:各种Skip-gram 300 -模型精度在类比推理任务8中定义。 NEG-K代表与每个正样本k阴性样品抽样负; NCE代表噪声对比估计和HS-霍夫曼表示分层SOFTMAX与基于频率的霍夫曼码。其中,f(WI)是单词w的频率,t是一个选择的阈值,通常约10

13、-5.我们选择这个二次抽样式,因为它积极的单词次级样本频率大于t的排名,同时保留频率。虽然这种二次抽样公式属于启发式选择,我们发现它在实践中很好地工作。它可以加速学习甚至显著提高的罕见字的学习的精度,这将在以下部分中所示被介绍。3实证结果在本节中,我们评估来分层Softmax(HS),大概包括噪音对比评估,负采样,二次抽样的试验。我们使用类比推理任务1来引入Mikolov 等。8。该任务包括类比,如“德国”的:“柏林”:“法”:?, 这是找到一个向量x,使得VEC(x)根据余弦距离(我们从搜索输入字)(“法国”)。 这个具体的例子被认为是已被正确地回答如果x为“巴黎”。该任务有两个大类:句法类

14、比(如“快速”:“迅速”:“慢”:“慢慢来”)和语义类比,如全国省会城市的关系。Skip-gram模型的试验,我们已经使用了大量的数据集,包括各种新闻报道(内置谷歌的数据集十亿字)。我们将词汇丢弃所有单词再训练数据,这导致尺寸692K的词汇发生不足5次。以上的字类比试验Skip-gram模型的性能列于表1。该表显示,抽样负优于分层SOFTMAX的类比推理任务,并有稍微大于噪声的对比更好的性能。该频繁的字二次采样提高了训练速度数次,让这个词表达更准确。可以说,skip-gram模型使其向量的线性更适合线性类比推理,但Mikolov等人的结果 8还表明通过标准的递归神经网络(其是高度非线性的)可以

15、改善这种情况,使得训练数据量增加,这表明非线性模型也有偏爱这个词表示的线性结构。4学习短语正如前面所讨论的,很多短语都有意义,他们并不是一个简单的组合单个单词,我们首先找到单词经常出现在一起的地方,很少在其他的情况。例如,“纽约时报”“多伦多枫叶”是由训练数据的独特记号代替,而两字“这是”将保持不变。表2:例子类比推理任务的短语(完整的测试集有3218个例子)。我们的目标是计算使用前三个第四句话。我们最好在这个数据集模型实现了72%的准确性。通过这种方式,我们可以形成许多合理的短语并且不会大幅提高词汇量的大小;在理论上,我们可以训练Skip-gram模型使用所有字格,但是这将会使得内存更加密集

16、。之前许多技术已经开发出了识别文本中的词语; 然而,它超出了我们的工作来所认识它们的范围,所以我们决定用一个简单的数据驱动的方法,其中,短语根据单字组和双字组计数形成的, (6)是作为折现系数,主要是为了防止太多的短语组成的非常罕见单词。如果有会出现频率高的单词,通常,我们运行2 - 4通过降低阈值的训练数据, 主要是用来防止几个单词较长的词组。我们评估这句话的质量的短语用一个新的类比推理任务表示。表2示出的例子的五类在这个任务中使用的类比。此数据集是在web2的公开。4.1 Skip-Gram短语结果从之前所得要的数据的基础上再进行实验,首先要根据训练资料来构造短语,然后我们用不同的超参数来

17、训练几个Skip-gram模型。像之前一样,我们使用向量维数300和上下文大小为5的设置。这个设置可以使数据集变得跟家良好, 而且可以让我们快速比较负抽样和分层SOFTMAX,这样就不会有有频繁的标记二次抽样。该结果归纳于表3中。结果表明,当负采样达到k= 5的时候就会达到可观的精度,当K =15取得的精度会跟家精确。出人意料的是,当我们下采样频繁的时候我们发现了分层SOFTMAX会获得较低的性能在不需要进行二次抽样培训的情况下,这使得它成为了最好的执行方法。这表明,至少在某些情况下,子采样可以导致更快的训练,也可以提高精度。表3:Skip-gram模型的精度度在于短语类比数据集。从新闻中知道

18、这个模型培训了大概十亿字。 表4:最接近给定实体的短语要使用两种不同的模型。表5:向量组合使用element-wise加法。四个载体中被标记的最近的两个最好用Skip-gram模型。整个句子的上下文中,为了最大限度地提高该短语类比任务的准确性,我们提高了训练数据的数量通过使用数据集,约330亿字。在全文中我们使用分层SOFTMAX模型,这导致模型的精度达到72。这样的话我们实现了低精度66%减少训练数据集的大小为6 b,这表明大量的训练数据是非常重要的。为了进一步深入了解不同型号模型表现的不同,我们便对相邻的短语模型做手工检查。在表4中,我们展示出了一个样品的比较。与之前的结果看来,似乎最好短

19、语表示是短语学模型与层次softmax和二次抽样。 5附加的语意组合性我们表明,单词和短语的线性结构表示由Skip-gram模型展示,使得它可以用简单的向量执行精确的类比推理运算。有趣的是,我们发现,Skip-gram模型表现出另一种线性的结构,使得它可以通过一个个元素的加法并且有意义的结合其他词语。这种现象在表5中示出。向量的加和性可以通过检查培训目标来解释。这个词向量的线性关系由softmax非线性输入。因为这个词向量,载体可以被看作是代表其中出现的单词在上下文的分布。这些值相关的对数由输出层计算概率,所以两条字向量涉及到这两个方面的分布产品。该产品在这里工作内容及功能:单词由这两个词向量

20、被分配,高的将具有高概率,以及换言之将有低概率。因此,如果“伏尔加河”在同一个句子频频出现,上面就会写着“俄罗斯”和“河”,这两个词向量的总和将导致这个词向量的意思,接近“伏尔加河”词向量。6 发布词表示的比较许多工作者曾经研究基于神经网络的表示方法,其中最知名的作者有Collobert、 Weston2、Turian 17、Mnih和Hinton10等人。我们可以从WEB3中下载他们的信息。 Mikolov等人 8已经评估了这些信息,其中Skip-gram模型可以实现最佳性能,并且可以获得巨大的利润。表6:在大家所认知的模型和skip-gram模型中拥有300亿个被使用过的子。空单元的话意味

21、着词不是词汇表中。给予更多的了解学习质量的差别向量,我们提供实证比较,显示最近的邻居罕见字在表6所示。这些例子表明,大Skip-gram模型训练大语料库明显优于其他模型的质量表示。这可以部分归结于这个modelhas培训约300亿字,大概是两到三个数量级中使用更多的数据比典型的大小之前的工作。有趣的是,尽管训练集大得多,训练时间Skip-gram模型的只是一小部分所需的时间复杂度先前的模型架构。7结论这项工作有几个重要的贡献。我们展示如何训练单词和短语与Skip-gram模型的分布式表示和证明这些表示线性结构,使精确的类比推理成为可能。本文介绍的技术也可以用于训练连续bag-of-words模

22、型中引入8。在我们成功的培训情况下所发布的机型数量比以前发布的机型数量多,这要归功于高效的计算机模型构架。这导致单词和短语陈述的质量得到了大的改善,尤其的对罕见的实体,我们还发现,频繁的二次抽样可以更好的表示常见的单词。我们论文的另一个贡献是消极的抽样算法,这是一个非常简单的训练方法。就是要学会准确的表示频繁出现的单词。训练算法和超参数选择是一个具体的任务的决定,因为我们发现,不同的问题有不同的最优超参数配置。 在我们的实验,影响性能的最重要的因素是该模型的选择架构,向量的大小,子采样率,和训练窗的大小。这项工作的一个非常有趣的结论是这个词向量可以用只是简单的向量加法将所有意义的结合起来。另一种学习的方法就是用简单的标记代表短语。结合这两种方法给出了一个简单但强大的方法如何利用最小的计算复杂度来表示时间的文本。我们的工作可以被看作是现有方法的补充,并试图代表短语来进行递归矩阵向量操作。在我们的代码的基础上提出来的关于词和短语的向量技术可以作为一个开源的项目。

- 温馨提示:

1: 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

2: 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

3.本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

5. 装配图网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。